荐读|生成式人工智能赋能新质生产力的隐私风险及协同治理

2025-06-17 | 查看: 10

杨清望,唐乾 中国科大知产院

作者简介

杨清望(1975—),男(土家族),湖南泸溪人,中南大学法学院,教授,博士,研究方向:法学理论;

唐乾(1995—),男,河南上蔡人,中南大学法学院,博士研究生,研究方向:法学理论。

摘要

生成式人工智能在推动新质生产力发展中发挥了重要作用,显著提升了生产效率和创新能力。然而,其对数据的高度依赖也带来了严重的隐私风险。生成式人工智能在新质生产力应用场景中对大规模、高精度数据的需求,常超出数据最小必要原则的范围,增加了过度数据收集的可能性。同时,算法的复杂性和生成内容的不可预测性,削弱了用户对个人信息的控制,导致信息透明度不足,进一步加剧了隐私风险。此外,跨行业和跨区域的数据共享使得用户知情同意难以充分实现。为应对这些挑战,需采用协同治理模式,通过多主体数据审查与权限分配机制确保数据处理最小化,减少过度收集的风险。通过动态内容生成监督与跨部门合规责任机制加强对生成内容的监管,提升用户信息控制权。通过透明的数据共享协作与分阶段同意机制,确保用户在跨行业、跨区域的数据流动中对其信息的有效掌控,最终实现AIGC技术发展与隐私保护的平衡。

关键词

生成式人工智能;新质生产力;个人信息保护;隐私保护;协同治理

新质生产力是科技创新在其中发挥主导作用的生产力[1],是经济高质量发展和社会深刻变革的重要基础[2]。生成式人工智能(Artificial Intelligence Gen erated Content,以下简称AIGC)作为推动新质生产力的重要力量,通过自然语言生成、图像生成、自动编程等技术手段,在制造业、医疗、教育、金融和文化创意等领域,优化资源配置、提升生产效率和增强创新能力,为全球数字经济崛起和国家竞争力提升注入了强大动力[3]。例如,在制造业中,AIGC通过自动化设计提升产品研发效率;在医疗领域,AIGC辅助诊断和药物开发缩短了研发周期;在教育领域,个性化学习方案提高了教育资源的利用率。然而,AIGC的广泛应用也伴随着隐私保护方面的严峻挑战,其模型训练高度依赖大规模数据收集,跨区域、跨领域的数据共享增加了个人信息泄露的风险,同时现有隐私保护技术难以全面应对,导致隐私治理滞后成为新质生产力发展的瓶颈。为解决这一挑战,亟须构建以协同治理为核心的多层次隐私保护框架,通过差分隐私、联邦学习等隐私增强技术[4],结合《中华人民共和国数据安全法》(以下简称《数据安全法》)、《生成式人工智能服务管理暂行办法》等法律法规,推动行业自律和公众参与,增强数据处理的透明度和安全性,在隐私保护与技术创新之间实现平衡,确保AIGC技术与新质生产力的可持续协同发展。

一、AIGC赋能新质生产力的隐私风险

01 数据过度收集与数据最小必要原则的冲突

在新质生产力发展的推动下,AIGC通过自然语言生成、图像生成和自动编程等技术,实现了生产效率的提升、资源配置的优化及创新能力的增强。然而,这些技术高度依赖大规模数据的获取和处理[5],尤其在跨领域应用中,其对多样化数据的需求常突破数据最小必要原则。平台通常通过整合社交媒体数据、匿名化信息,甚至推测用户敏感数据以优化模型训练效果,尽管提升了技术能力,却显著增加了个人隐私泄露的风险。同时,AIGC的“自我学习”和“反馈优化”机制进一步扩大了数据收集范围,用户对其信息的流动和用途缺乏有效控制。部分平台在数据收集中未明确告知用户具体用途,通过隐蔽方式收集数据,严重侵害用户的知情权和选择权。例如,苹果公司的Siri和亚马逊的Alexa在未经用户知情情况下自动记录和存储语音数据,并上传云端优化服务[6]。这些现象挑战了个人信息最小化原则的法律要求,加剧了隐私保护与技术发展的矛盾,成为新质生产力发展的严重隐患。这不仅是技术与法律之间的冲突,也揭示了在数据驱动社会中,权利保障与技术进步之间难以调和的深层张力。

第一,AIGC系统对多样化数据的依赖直接违背个人信息最小化原则。AIGC需要处理的大量个人信息涉及文本、图像、用户行为、偏好和情感等,这与《中华人民共和国个人信息保护法》(以下简称《个人信息保护法》)的隐私保护原则直接矛盾。《个人信息保护法》第六条要求数据收集应符合必要性和合法性,但平台为提升技术效果,常扩大数据收集范围。例如,2023年4月,意大利数据保护机构暂时禁止ChatGPT,原因在于其未经用户同意收集个人数据,且未能证明大规模收集的合理性,违反了最小化原则和透明性要求[7]。这表明,AIGC为完成复杂任务所需的数据常超出用户预期,违反了最小化原则。

第二,AIGC的复杂算法加剧了数据用途的不透明性,使用户难以掌控数据处理方式。AIGC系统依赖复杂算法生成结果,自动化处理的高度复杂性让用户难以了解数据如何被使用。《个人信息保护法》第七条要求数据处理需遵循透明原则,明确告知用户数据的用途和方式。然而,许多平台仅通过模糊隐私政策让用户同意,未说明具体用途。例如,谷歌的AI产品Bard曾因未明确告知用户而收集对话数据用于模型训练,引发争议。这种隐私政策中的“灰色地带”使用户的数据易被平台和第三方滥用,增加信息泄露的风险[8]。

第三,数据保护与技术发展的矛盾在AIGC的迭代升级中尤为显著。AIGC依赖大量数据输入和多次迭代提升模型智能化水平,但《个人信息保护法》和GDPR要求数据处理遵循最小化原则,限制数据收集范围。这种限制直接影响了AIGC模型的训练质量。例如,为符合GDPR要求,OpenAI限制了ChatGPT的数据收集,尤其是在用户生成内容和敏感信息方面,导致模型在某些任务中的表现受限,影响其在欧洲市场的泛化能力。

02 生成内容不可预测性与信息控制权的冲突

在新质生产力的应用场景中,AIGC内容的不可预测性愈加突出[9]。依托复杂算法和海量数据,AIGC在生成文本、图像和视频等内容时,其路径和结果往往超出预期,导致信息控制权面临全新挑战。这种不可预测性表现为:一方面,AIGC整合多样化数据生成内容时,可能涉及用户未授权的信息推测和数据挖掘,削弱个人隐私和商业秘密保护;另一方面,生成内容可能误导用户或引发伦理争议,尤其是在医疗健康、金融分析等依赖精确数据的领域。此外,内容归属和责任界定的模糊性,使信息主体难以掌控自身数据的使用情况。

第一,AIGC内容的不可预测性源于其依靠深度学习、自然语言处理等算法自动生成文本、图片和视频。这种生成方式需要处理海量数据,通过模型参数和算法实现数据转换与推演,因此生成内容无法完全预测[10]。与传统人工生成方式不同,AIGC基于多样化输入数据,可能生成包含隐私信息、误导性商业数据或不符合道德规范的内容。这直接削弱了信息主体对生成内容的控制能力,使其在保护个人信息和权益时面临更大的不确定性。例如,AIGC可通过整合互联网数据生成涉及个人隐私的内容,这些内容并非信息主体直接提供,而是通过公开数据或第三方数据推测得出,导致信息主体难以预见哪些信息会被生成。此外,生成内容可能被进一步商业化或用于数据挖掘,信息主体对此不知情,进一步削弱其控制权。

第二,AIGC发展打破了信息控制权的传统法律框架。信息控制权通常指信息主体对其个人信息享有的知情权、同意权、访问权、删除权和修改权等,确保信息合法使用[11]。在传统法律环境下,信息主体通过授权允许特定用途下的数据使用,且有权要求删除或停止处理。但AIGC不仅基于合法收集的数据生成内容,还可能通过算法推演生成未经授权的衍生信息,这意味着信息主体不再完全拥有对生成内容的控制权。尤其当生成内容涉及个人隐私或商业秘密时,主体难以掌控。例如,某些AI系统生成文本时可能无意中引用或推测出信息主体未公开的私人信息,信息主体对此无能为力。这表明,AIGC时代挑战了传统信息控制权概念,现有法律框架难以充分保护信息主体的权利。

第三,信息控制权与生成内容不可预测性产生直接冲突。首先,AIGC的不可预测性使信息主体难以控制生成内容,尤其当系统依赖庞大数据集推演时,主体难以掌握内容的形式和范围,削弱了数据使用权。《个人信息保护法》第四十四条规定个人有权知晓、决定、限制或拒绝对其信息的处理,但AIGC的自动化特性削弱了这些权利。例如,2016年微软AI聊天机器人Tay在吸收用户输入后迅速生成偏见内容,导致公关危机[12],凸显AIGC系统对信息控制权的侵蚀。其次,AIGC生成内容的法律归属模糊。传统法律赋予信息主体对个人数据的控制权,但生成内容由多方数据和复杂算法生成,难以归属至某一主体。《中华人民共和国著作权法》第十条规定作者享有署名权,但AIGC生成内容是否构成作品仍存争议。例如,2023年Getty Images对Stability AI的诉讼反映了AIGC生成内容归属问题的法律盲区[13]。此外,即使内容与信息主体原始数据相关,其高商业价值可能引发新的控制权问题。最后,隐私保护与生成内容中的潜在风险并存。AIGC系统可能在生成内容时无意中泄露隐私或敏感信息。《个人信息保护法》第五十一条规定数据处理者应防止信息泄露,但AIGC的自动生成特性使主体难以监控内容。例如,OpenAI发布的GPT-2模型因可能生成私人对话记录而被限制公开[14]。这表明,AIGC生成内容可能泄露未经授权的隐私信息,而信息主体对此无法掌控,面临隐私权被侵害的风险。

03 数据共享与个人信息知情同意原则的冲突

新质生产力以数据驱动和协同共享为核心,通过多主体协作提升生产效率并推动经济高质量发展。然而,这种以数据共享为基础的生产模式与个人信息保护中的知情同意原则产生了严重冲突。AIGC作为新质生产力的重要工具,在跨行业、跨领域的数据共享过程中,用户个人信息的流转范围常超出其知情和掌控能力。复杂的共享网络使用户难以明确其数据在多平台间的具体流向,导致知情同意名存实亡;同时,企业为优化服务精准度和实现个性化功能,扩大数据使用范围,侵蚀用户隐私保护权[15]。此外,企业对商业利益的追求加剧了信息滥用和安全问题,使隐私风险进一步升级。这种冲突已成为AIGC赋能新质生产力的核心法律挑战,急需通过技术手段和制度创新加以平衡。

第一,法律层面的冲突:知情同意原则的有效性受限。知情同意作为个人信息保护的重要基石,源于信息主体对其信息的控制权。然而,在复杂的数据共享环境中,知情同意的有效性受限。《个人信息保护法》第六条要求个人信息处理应遵循合法、正当和必要原则,并基于明示同意。但AIGC系统中,由于大量数据共享与平台间复杂交互,信息主体难以掌握其信息的流转过程。例如,在公共法律服务中,用户的行为数据和服务记录常在多个平台间交换,尽管提升了个性化服务,但用户往往不清楚数据的具体流向。《个人信息保护法》第三十八条规定跨境数据流动需取得单独同意,但在电子商务和国际交易中,用户数据常被未经充分告知的情况下共享。Facebook数据泄露事件即为典型案例[16],暴露了用户对数据跨境流动的掌控力不足,知情同意原则在这种复杂环境中受到了极大挑战。

第二,实践操作中的冲突:用户选择权的弱化。AIGC系统通过隐私政策隐藏和复杂条款,使用户对数据共享的知情同意流于形式,选择权受限。《个人信息保护法》第十七条要求以显著方式告知用户数据处理目的和方式,并提供行使选择权的途径。但许多平台通过默认勾选或不透明条款,难以让用户清楚了解数据具体流转路径。例如,一些法律服务平台使用AIGC技术生成个性化解决方案,将用户行为数据与第三方共享,而用户仅通过隐蔽条款授权了全面流转,失去对具体使用环节的控制。2023年,OpenAI的ChatGPT被用于生成法律文件和个性化服务,但用户并未完全知晓其信息如何被使用,这种隐蔽操作削弱了用户选择权,加剧了隐私风险。

第三,社会影响层面的冲突:商业利益与个人隐私的权衡。数据已成为推动商业发展的关键要素,企业通过用户行为数据分析提供个性化服务并实现精准营销。但这种数据共享模式直接侵害了用户隐私权。《个人信息保护法》第五十一条要求数据处理者确保数据安全,但企业在追求商业利益时常忽视隐私保护。例如,滴滴出行涉嫌将用户出行记录与第三方共享,且未充分告知用户具体范围,被监管机构调查[17]。这种商业行为虽提升了效率,却牺牲了用户对个人信息的控制权,并引发信息滥用风险。近年来,数据泄露事件频发,Facebook和滴滴等案例表明,企业安全保障机制的不完善会严重侵害个人隐私。

二、AIGC协同治理的逻辑证成

01 AIGC协同治理的内涵

协同治理的理念源于复杂社会系统对有效治理的需求[18],也是促进新质生产力健康发展的关键路径。在全球化与科技发展的背景下,特别是数字经济与人工智能技术的广泛应用,传统单一主体的监管模式难以应对AIGC带来的隐私风险与法律挑战[19]。通过政府、企业、学术机构、技术社区和公众等多主体协作,协同治理能够整合资源,解决技术快速发展中的复杂问题,实现隐私风险的有效防控,为新质生产力的高效、安全发展提供制度保障。AIGC协同治理以多主体参与、技术与法律融合、数据透明化和公众广泛参与为核心。各方需共同制定标准与规范,并推动AIGC技术为新质生产力提供具体赋能。例如,政府通过政策引导和监管,确保数据共享和使用合法合规;企业采用技术手段如数据加密和差分隐私工具,加强对个人信息的保护;行业技术社区和公众共同参与,提升治理透明度和社会信任度。这一模式将隐私风险降至最低,为AIGC技术的发展创造健康、可持续的环境,同时将新质生产力的创新目标融入治理体系。

第一,AIGC协同治理的核心是多主体参与的动态机制。传统自上而下的监管模式强调政府主导、单向控制和强制执行[20],而协同治理要求政府、企业和社会组织通过对话与合作,共同制定规则。政府不仅提供政策框架,还须推动企业和技术社区承担更多社会责任。具体的技术实施规范由技术社区和行业标准组织共同制定,使治理机制更具灵活性和适应性。

第二,AIGC协同治理强调技术与法律的融合。AIGC技术的复杂性要求法律保障与技术手段相结合。例如,数据隐私保护仅依赖法律规范难以解决问题,需要结合加密算法和人工智能的自律机制。推动技术自我调节和风险防范是协同治理的重要内容,技术企业应引入伦理和合规考量,确保在设计阶段实现个人数据保护与最小化处理等原则。

第三,协同治理中的数据共享和透明性是重要组成部分。AIGC的广泛应用涉及跨平台数据共享和使用,协同治理需确保数据的透明化和合规性。例如,在公共法律服务领域,AIGC可自动生成法律建议或文书,这些过程常涉及用户数据的跨平台传输和处理。通过平台透明化和数据可追溯机制,确保数据共享每一环节符合法律规定,保护用户隐私和知情权。

第四,协同治理要求公众和用户的广泛参与[21]。用户作为AIGC内容的生成者和受益者,其参与不仅是治理的伦理基础,也是治理有效性的保障。协同治理目标是确保用户对AIGC技术的充分知情,并赋予其选择权与监督权。平台需在隐私政策和数据使用条款方面更加透明,同时通过用户教育和技术普及,让公众了解AIGC技术的潜在风险和权利保障途径。

02 AIGC协同治理的必要性

AIGC技术的快速发展在推动技术进步和经济效益提升的同时,也带来了隐私保护和法律合规的挑战,成为制约其赋能新质生产力的重要瓶颈。如果缺乏有效的隐私风险治理,可能导致用户信任流失、数据共享受阻以及法律问题累积,从而阻碍技术创新应用和推广。《数据安全法》《个人信息保护法》等法规为构建协同治理框架提供了法律基础,强调通过多主体协作应对隐私风险,保障AIGC的可持续发展。

第一,法律基础为协同治理提供支撑。《数据安全法》第二十七条要求数据处理者建立覆盖数据全生命周期的安全管理制度,包括收集、存储、传输、处理和共享等环节,确保数据合法性和安全性。第二十九条进一步要求强化风险监测,在安全事件发生时及时补救并向用户和监管部门报告。第三十条要求企业对重要数据定期评估并提交报告。这些条款为协同治理构建了“政府、企业和第三方”协作框架,明确了各主体职责,为多主体参与提供了法律依据和操作指引。

第二,数据依赖与治理需求的冲突。AIGC技术对海量数据的依赖与法律规定的最小必要原则形成矛盾。《数据安全法》第三十二条要求数据收集必须合法、正当,《个人信息保护法》第二十九条则规定敏感个人信息的处理需取得用户单独同意。然而,AIGC在医疗健康和金融服务等领域的模型训练需求,往往突破法律许可范围,增加隐私泄露和数据滥用风险。这种冲突凸显协同治理的必要性。通过政府严格审查、企业内部自律和第三方独立评估,可以平衡技术发展与法律合规需求,为技术创新和隐私保护提供保障。

第三,构建协同治理的闭环机制。协同治理核心在于“政府监管、企业自律、公众参与、第三方监督”四位一体的闭环机制。《数据安全法》第三十三条和第三十四条要求数据交易中介机构审核数据来源并保存交易记录,同时政府需定期检查数据交易合规性。政府监管机构负责数据处理的前置审查,要求企业提交详尽的数据处理计划并持续报告合规性;企业通过内部审查和动态风险监控,及时纠正潜在问题;第三方机构通过外部审计和用户反馈,增强治理透明度和问责性。此外,公众参与在这一闭环中不可或缺,通过透明界面设计和落实知情权提升社会监督力度,强化数据治理合法性。

第四,国际合作与社会责任的必要性。在全球化背景下,AIGC技术的竞争不仅是国家科技实力的较量,更是国际合作与治理的重要内容[22]。AIGC协同治理的需求还延伸至国际层面,中国应推动全球治理规则的形成,同时确保技术应用的公平与透明,避免算法歧视或数据滥用引发社会信任危机。例如,金融领域需保障决策过程公平,避免数据偏差损害弱势群体利益。通过多主体协同,中国在全球技术治理中不仅能发挥领导作用,还能推进技术的社会责任落实,促进经济和社会可持续发展。

03 AIGC协同治理的可行性

AIGC协同治理的可行性体现在其能够在推动技术赋能新质生产力的同时,又能平衡隐私保护与创新发展的需求。通过政府、企业、学术界和公众的多方协作,协同治理为技术发展与法律规范之间的矛盾提供了解决路径,也为社会责任与技术创新的持续发展奠定了基础。

第一,理论基础:多方互动与合作性[23]。AIGC技术的复杂性和广泛影响决定了单一主体无法全面监管其应用及衍生问题,协同治理因此成为应对隐私风险和技术挑战的必要手段。《数据安全法》第二十七条要求数据处理覆盖全生命周期,强调多主体协作。这种互动包括政府制定政策和监管框架,企业及技术社区参与标准制定和自律管理,公众通过监督机制保障合法权益。协同治理通过多层次合作,平衡技术发展与社会责任,确保治理效果的系统性和全面性。

第二,法律法规支撑:制度保障。在《个人信息保护法》《数据安全法》《生成式人工智能服务管理暂行办法》等法规框架下,AIGC的协同治理得到了强有力的法律支持。《数据安全法》第二十九条强调风险监测和应急响应,而《个人信息保护法》第六条和第十三条明确了数据处理的合法性和必要性原则,特别是敏感数据需获得明确同意。这些法律为多主体协作提供了操作指引,确保各方在法律框架下规范参与治理,防止数据滥用或隐私泄露,提高数据处理活动的透明度和合法性。

第三,政策导向:高质量发展与现代化治理。党的二十届三中全会提出“高质量发展必须以现代化的治理能力为支撑”,为AIGC协同治理指明了方向。完善的法治体系和多方协同机制能够在保障隐私和数据安全的同时促进科技创新。例如,在医疗和金融等敏感领域,政府通过政策引导,结合企业技术应用与公众监督,实现技术创新与社会责任的平衡。这种治理模式为AIGC在健康可控环境中的发展奠定了基础,并助力中国式现代化。

第四,行业自律与技术标准:企业和技术社区的责任。行业自律和技术标准是协同治理的重要支柱,2024年发布的《生成式人工智能行业自律倡议》要求企业遵守数据安全与隐私保护法律,通过建立统一标准和自律机制减少隐私和数据安全风险。同时,技术社区推动技术透明化与创新解决方案,进一步增强协同治理的规范性和可操作性。

第五,公众参与:知情与监督的机制保障。公众作为数据提供者和隐私保护的核心利益方,其参与是协同治理的关键。《个人信息保护法》第四十四条规定公众享有个人信息处理的知情权和选择权。通过透明的界面设计和信息披露,公众能够了解数据处理情况并监督技术应用。这种广泛参与不仅提升了治理的民主性和开放性,还强化了社会对技术进步的信任,确保技术开发与社会利益的平衡。

三、协同治理下AIGC隐私风险的治理机制

01 多主体数据审查与权限分配机制

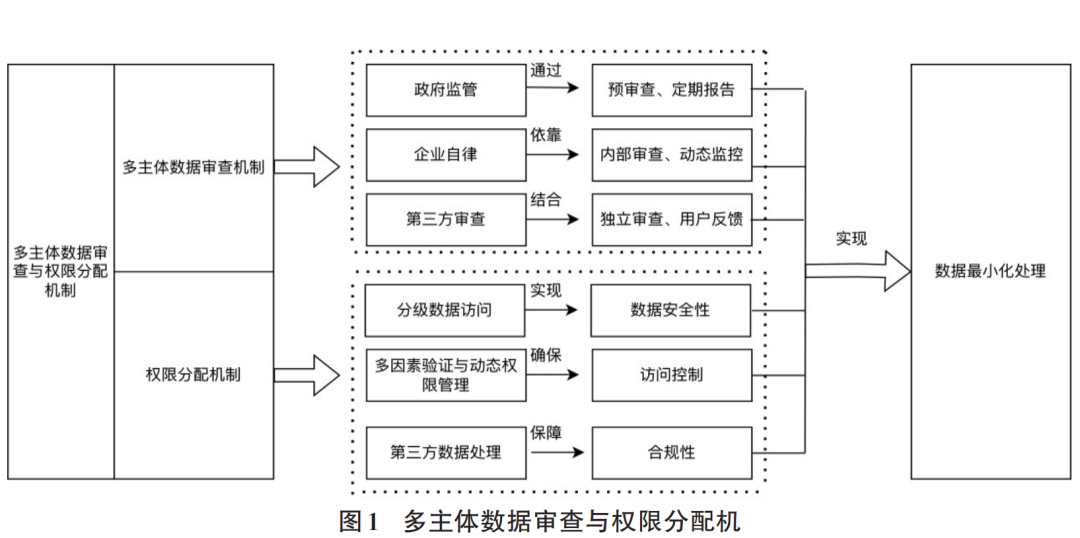

在多主体数据审查机制(见图1)中,政府通过预审查与定期报告,落实《数据安全法》第二十七条关于“建立健全全流程数据安全管理制度”的要求,并依据第三十条推动企业对重要数据定期开展风险评估与合规报告。这不仅明确了数据使用边界,还保障了数据处理活动的合法性与安全性,满足AIGC对高质量数据的需求,为新质生产力的创新发展奠定基础。企业通过内部审查与动态监控,履行《数据安全法》第二十九条“数据风险监测与补救”的义务,既能降低隐私泄露风险,又能通过动态调整与技术优化满足新质生产力对实时数据的需求。此外,第三方机构通过独立审查与用户反馈机制,加强了外部监督的透明性与社会参与的广泛性,在平衡数据合规要求与技术创新动力的同时,提升了治理的公信力与实效性。

在权限分配机制方面,分级数据访问权限符合《数据安全法》第二十七条规定的技术安全要求,通过精准划分敏感数据访问权限,既提升了隐私保护水平,又确保了关键数据的高效流转,从而支持新质生产力对数据共享与协作的需求。同时,多因素验证与动态权限管理结合了《数据安全法》第二十八条中“数据处理活动需符合社会公德和伦理”的原则。这一机制在保障数据访问安全性的同时,允许根据任务需求动态调整权限,最大化支持AIGC在多场景中的创新应用。尤其是在第三方数据处理环节,实时监督与自动化权限管理机制不仅符合《数据安全法》第三十三条与第三十四条的要求,还通过高效的权限分配与合规审查,确保了数据使用的合法性和合理性,为新质生产力的发展提供了重要支撑。

1.多主体数据审查机制

《数据安全法》第二十七条要求建立全流程数据安全管理制度,并采取必要措施保障数据安全。《个人信息保护法》第六条和第十三条进一步规定,数据处理活动需遵循合法、正当、必要原则,确保数据收集不超出实现处理目的的范围。然而,AIGC技术对海量数据的依赖可能导致企业突破“最小必要原则”,甚至出现过度数据收集问题。为此,应建立多主体数据审查机制,在数据收集与处理的各个环节引入严格的前置和后续审查[24],形成由政府监管机构主导全局监管、企业合规部门加强动态自律以及独立第三方审查机构与用户反馈补充监督的监管闭环。

第一,政府监管:预审查与定期报告。国家互联网信息办公室等机构需主导数据管理,要求企业在数据收集前提交详细处理计划[25],包括目的、范围、期限和方式。前置审查机制提升数据使用透明度,避免企业在数据收集初期违反最小必要原则。同时,定期审查与合规性报告能确保数据处理过程符合法律规定。尤其是在处理敏感数据时,如健康信息和金融数据,企业需制定专门审查流程以保障合规。

第二,企业自律:内部审查与动态监控。企业需建立自我审查机制,定期检查数据存储、传输和共享的合规性,并对潜在风险进行动态监控。特别是在AIGC系统开发与应用中,新数据的收集与处理必须经过合规评估,并向政府提交报告。企业还需加强员工培训和责任追溯,确保相关人员熟悉法律要求,及时发现并纠正违规行为。

第三,第三方审查与用户参与。独立的第三方机构可对企业数据处理行为进行客观评估,发现问题后及时采取纠正措施,为企业提供双重监督。此外,用户参与机制确保其知情权和决策权,用户可通过透明界面查看数据使用情况,并随时调整或撤回授权。用户反馈还能为第三方审查提供参考,提升数据治理透明性和合法性。例如,GDPR要求企业在收集用户数据前进行数据影响评估(DPIA),以确保数据处理风险可控[26]。结合我国《个人信息保护法》和《数据安全法》的要求,尤其在处理跨境数据和AIGC数据训练时,通过严格的第三方审计和用户监督,有助于减少隐私风险,增强数据处理的合规性。

2.权限分配机制

第一,严格分级数据访问权限。在AIGC系统中,分级管理是确保数据隐私和安全的基础。高敏感性数据如个人身份信息、健康记录、财务数据等,必须采用加密、匿名化或去标识化方式处理,且仅限特定任务所需人员访问。《个人信息保护法》第四十四条要求,敏感数据处理必须遵循最小化原则,防止过度收集和滥用。企业应采用强制加密、端到端加密及数据分块加密等多重保护措施,以防数据在传输和存储过程中被截取或泄露。同时,定期审核权限设定,确保访问权限合理,并严格按照规定使用数据,避免敏感数据被不必要地访问。

第二,多因素验证与动态权限管理。为增强数据访问安全,企业应采用多因素验证(MFA)与零信任安全框架。这些措施结合密码保护、生物识别(如指纹或面部识别)、验证码及硬件令牌等多种验证方式,确保仅合法授权用户可访问数据。在AIGC系统中,鉴于数据量大且敏感度高,此类验证机制尤为重要,可有效防止因权限泄露导致的隐私风险。此外,企业应采用动态权限管理系统,通过实时监控与审查,根据实际需求调整权限。例如,任务完成后自动收回数据访问权限,避免长期开放带来的风险,定期清理历史权限可进一步保障数据安全。

第三,外部审查机制与第三方数据处理。企业与第三方共享数据时需设定严格边界,确保第三方仅访问必要数据。《数据安全法》和《个人信息保护法》要求,涉及用户个人信息的第三方服务(如支付处理或数据分析)需经过严格合规审查,并签订明确的法律协议,规范数据使用范围与目的[27]。企业应通过访问日志记录与监控系统实时追踪第三方的数据使用行为,确保其合规操作。此外,第三方需接受定期独立审计以验证数据使用合法性和合规性。企业还应引入自动化权限管理工具,及时更新和核查第三方权限,防止权限超出范围。若发现第三方滥用数据,需立即冻结其权限并启动内部调查,保障用户隐私权不受侵害。

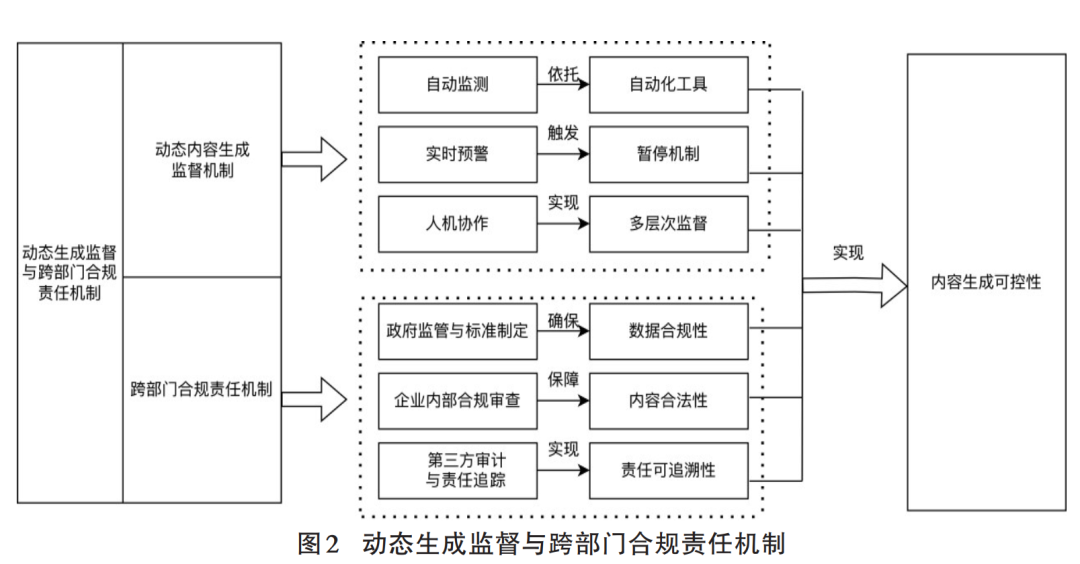

02 动态生成监督与跨部门合规责任机制

动态生成监督与跨部门合规责任机制(见图2)以现行法律为基础,并结合创新实践,为AIGC赋能新质生产力提供隐私保护与合规发展的双重保障。此外,在动态生成监督方面,《数据安全法》第二十七条要求建立全流程安全管理制度,第二十八条强调数据处理需符合社会公德与伦理;《个人信息保护法》第二十九条明确处理敏感数据时需具备实时监测与补救能力。这些法规为动态生成监督和实时预警机制奠定了法律依据。基于此,本文引入自动化工具提升监测效率,并结合人机协作,实现多层次监督,确保生成内容的精准性与灵活性,同时满足新质生产力的数据需求。

1.动态内容生成监督机制

第一,自动化监测与筛查工具的应用。AIGC技术依赖复杂算法和海量数据生成内容,其不可预测性对用户隐私和信息控制权构成挑战。为此,平台应通过自动化监测和筛查工具进行实时分析。这些工具利用机器学习和人工智能技术,识别潜在隐私泄露或法律风险,尤其针对个人信息和敏感数据进行自动监测。例如,当系统检测到未经授权的个人数据被用于生成内容时,可自动触发警报并暂停发布。这种机制符合《个人信息保护法》第六条的数据最小化要求,有效减少用户数据的滥用风险,特别是在处理医疗数据和残障人数据等敏感信息时,确保每一生成阶段符合法律规范。

第二,实时预警与暂停机制。针对AIGC生成内容可能引发的隐私或法律问题,平台需建立实时预警和暂停机制。通过敏感内容识别模块,系统在发现未经授权的个人信息被利用时,需立即暂停内容生成或发布[28]。这种机制不仅可保护个人隐私,还能防止生成不当或违法内容。例如,在生成法律文件或公共信息时,通过多层次的内容预警和暂停操作,可避免自动化生成导致的错误传播。

第三,人机协作的多层次动态监督。尽管自动化工具在内容监督中发挥重要作用,但仅依赖自动化可能不足。在处理复杂问题时,需引入人机协作的多层次监督机制。平台应配备专业人员,在系统无法自动处理或识别潜在风险时进行人工干预和审核。例如,在法律、金融和公共服务等高敏感领域,引入人工审核机制确保生成内容符合法律和行业标准。通过人机协作,平台可保障内容的技术、法律和伦理合规性,降低因自动化判断失误带来的风险。

2.跨部门合规责任机制

第一,政府监管主导与合规标准制定。政府监管机构应主导制定法律合规标准和实施细则,涵盖隐私保护、数据使用和内容生成等领域[29],确保法律规范与AIGC技术特点相结合。例如,国家互联网信息办公室和市场监管机构应针对算法透明性和生成内容的合规性制定专项监管政策。这些政策要求平台在内容生成前进行风险评估,并备案涉及用户敏感信息的操作,确保生成内容的每个环节均符合合规要求。

第二,企业内部合规部门与自律审查。企业需设立专门的合规部门,动态监督AIGC内容生成的全过程,确保技术系统符合法律要求[30]。合规部门需定期对生成内容的合规性进行审查,并为敏感数据的生成和使用建立详细记录以供追溯。此外,企业应定期提交合规报告,与监管机构保持合作,确保法律动态与合规策略同步。例如,在生成法律服务类内容时,企业应建立专门的合规审核小组,逐一审查生成内容,以避免隐私侵害和法律违规。

第三,第三方审计与责任追踪机制。引入独立审计机构对AIGC内容生成流程进行定期审查,确保企业遵守法规和标准[31]。独立审计不仅监督企业行为,还提供公平透明的合规环境。责任追踪机制需明确生成内容责任的归属,并为每份生成内容建立详细的合规记录,确保在问题发生时迅速找到责任主体,减少法律纠纷。这一机制通过多方监督与追踪,不仅防止合规失误,还能提升公众对AIGC平台的信任。

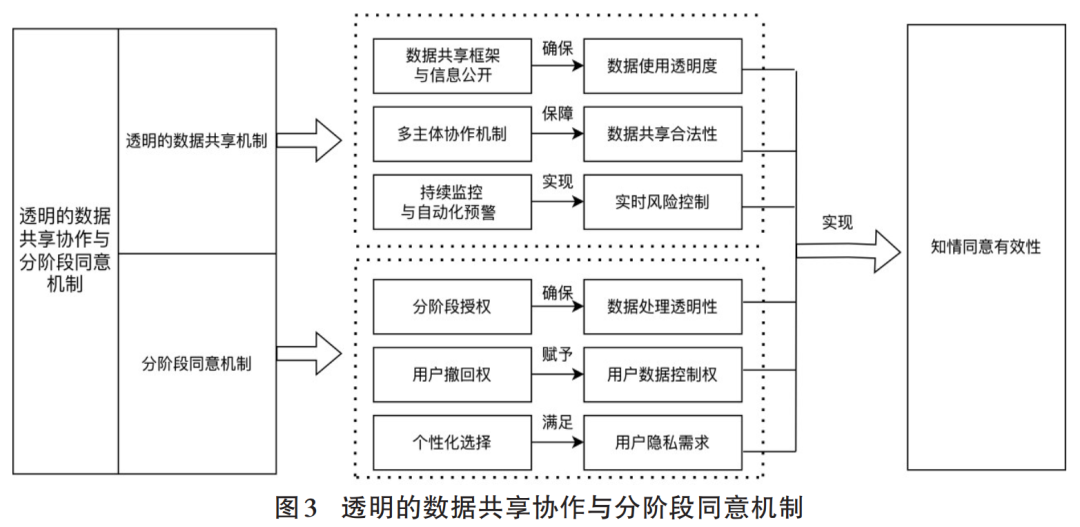

03 透明的数据共享协作与分阶段同意机制

透明的数据共享协作与分阶段同意机制(见图3)的设计,旨在平衡数据共享的合规性与隐私保护的有效性,为AIGC赋能新质生产力提供数据支持。在透明的数据共享机制中,《数据安全法》第二十七条要求建立全流程数据安全管理制度,第三十二条明确数据合法、正当使用的规定,要求数据处理者履行信息公开和透明管理义务;多主体协作机制则依据第二十九条和第三十条,通过动态风险监控与定期评估,确保数据共享的合法性与安全性。此外,通过持续监控与自动化预警机制,利用技术手段实时控制风险,进一步提高数据共享过程的监管效率。在分阶段同意机制中,分阶段授权与用户撤回权的设置满足了《个人信息保护法》第二十九条和第四十四条的法律要求,并通过个性化选择功能,赋予用户调整隐私偏好的灵活性,从而实现隐私保护与数据共享的平衡。这一机制既支持新质生产力对数据高效流转的需求,又增强了隐私保护的广度与深度。

1.透明的数据共享机制

第一,数据共享的透明框架与信息公开。在数据共享过程中,建立透明框架尤为重要。平台和企业应向用户清晰披露数据的收集、存储、处理和共享情况,包括数据类型、共享对象、目的、使用期限及处理方式[32]。这些信息应通过用户友好的界面展示,方便用户了解其数据的使用情况并追踪数据流动。此外,区块链等技术可作为技术保障,确保共享环节的可追溯性,避免未经授权的使用或数据篡改。这一机制不仅符合《个人信息保护法》和《数据安全法》的要求,还能增强用户对平台数据处理的信任。

第二,多主体数据共享协作机制。数据共享涉及多个主体和平台,需要明确各方的责任与角色。政府机构应制定数据共享的标准与规则,企业需确保共享过程符合法律要求并接受外部审查。同时,平台可与第三方审计机构合作,定期对数据共享过程进行独立评估,保障合规性与透明性。这种多主体协作机制有效减少数据泄露风险,防止数据被过度使用或非法传播,同时明确各方责任。

第三,持续监控与自动化风险预警系统。平台需建立持续监控与自动化风险预警系统,确保数据共享的合法性和安全性。通过机器学习和人工智能技术,实时监控数据使用情况,尤其针对敏感数据和个人信息,应设立监控机制以确保数据共享符合既定目的和法律要求。当出现不当使用或超出范围的共享行为时,系统应自动报警并暂停相关操作。此外,平台需定期向用户和相关方提供数据使用报告,展示数据流动情况及合规性审核结果。此类监控与预警系统有助于确保共享过程的安全性,降低法律风险与数据泄露隐患。

2.分阶段同意机制

第一,分阶段授权与数据处理透明化。分阶段同意机制要求用户对每个数据处理阶段单独授权,而非一次性授权整体使用。平台需在每个阶段操作前明确告知数据的使用目的、处理方式及涉及的第三方,使用户清楚了解数据如何被利用,并根据实际需求作出决策。例如,在广告投放、个性化推荐或跨境数据传输等场景,用户应被告知具体操作信息,确保在充分知情的情况下进行选择。此透明化过程不仅符合《个人信息保护法》对知情同意的要求,也能有效防止数据被滥用或超出用户预期。

第二,用户控制的灵活性与撤回权。分阶段同意机制的核心是赋予用户灵活调整和撤回授权的权利。平台应提供简便的操作界面,使用户能在数据处理的各阶段实时修改或撤回授权。例如,用户在数据被第三方处理前决定撤回授权时,平台需立即停止数据使用并删除存储。这种灵活性机制增强了用户对数据的控制感,同时符合法律关于数据撤回的规定,有效保护用户的个人信息权利。

第三,用户授权管理与个性化选择机制。平台需为用户提供个性化的数据授权管理选项,允许其根据数据类型或用途设定授权条件[33]。例如,用户可选择允许平台基于行为数据提供个性化内容,但拒绝共享个人身份信息给第三方广告商。通过详细的授权选择界面,用户可以灵活调整隐私偏好。此机制不仅提升了数据使用的合规性,还为用户提供更精准和灵活的隐私控制方式,同时增强对平台数据处理行为的信任。

四、结语

AIGC技术的快速崛起正推动新质生产力的变革,但同时也带来了隐私风险和治理挑战。党的二十届三中全会强调在推进中国式现代化中统筹发展和安全,为AIGC的隐私治理指明了方向。生成内容的不确定性、数据处理的复杂性和跨领域数据共享性,模糊了个人信息的边界,进一步加剧了隐私泄露和信息控制权的冲突。传统法律框架难以全面应对这些新问题,迫切需要从治理机制和法律制度上进行调整。基于协同治理理念,AIGC隐私治理应重点关注多主体数据审查、动态内容生成监督和跨部门合规责任机制。通过实时监督与多方协同治理,能有效应对生成内容的不确定性,保障用户信息控制权,降低隐私侵权风险。此外,应坚持包容审慎的监管理念,通过分阶段用户同意机制和多层次责任分配,确保AIGC技术在推动新质生产力发展时,兼顾隐私保护与社会责任,实现技术进步与社会安全的平衡。

参考文献

[1]习近平经济思想研究中心.新质生产力的内涵特征和发展重点(深入学习贯彻习近平新时代中国特色社会主义思想)[N].人民日报,2024-03-01(09).

[2]侯冠宇,张震宇.新质生产力赋能共同富裕的理论逻辑、关键问题与现实路径[J].云南民族大学学报(哲学社会科学版),2024,41(3):93 100.

[3]黄旭,洪美玲.生成式人工智能助力数字经济高质量发展的影响机制与提升路径[J].南方经济,2024(8):23 44.

[4]BANSE A,KREISCHER J.Federated Learning with Dif ferential Privacy[EB/OL].(2024-02-03)[2024-09-03].https://doi.org/10.48550/arXiv.2402.02230.

[5]KUNG T H,CHEUNG S,LIN Y.Performance of ChatGPTon usmle:Potential for AI-Assisted Medical Education Using Large Language Models[J].PLOS Digital Health,2022(2):1 12.

[6]BRÄUNLEIN F,FRERICHS L.Smart Spies:Alexa andGoogle Home Expose Users to Vishing and Eavesdrop ping[EB/OL].(2019-10-20)[2024-09-27].https://www.srlabs.de/blog-post/smart-spies.

[7]GARANTE P.Intelligenza Artificiale:Il Garante BloccaChatgpt.[EB/OL].(2023-03-31)[2024-09-01].https://www.garanteprivacy.it/home/docweb/-/docweb-display/docweb/9870847.

[8]CHEN J,HE J,CAI L,et al.Disclose more and risk less:Privacy preserving online socialnetwork data sharing[J].IEEE Transactions on Dependable and Secure Comput ing,2018(6):1173 1187.

[9]WACH K,KUPRIANOV A,ZHANG T.The dark side ofgenerative artificial intelligence:A critical analysisof con troversiesand risks of ChatGPT[J].Entrepreneurial Busi ness and Economics Review,2023,11(2):1 3.

[10]蒲清平,向往.生成式人工智能——ChatGPT的变革影响、风险挑战及应对策略[J].重庆大学学报(社会科学版),2023,29(3):102 114.

[11]刘士国.信息控制权法理与我国个人信息保护立法[J].政法论丛,2021(3):80 91.

[12]WAKEFIELD J.Microsoft chatbot is taught to swear onTwitter[EB/OL].(2016-03-24)[2024-09-20].https://www.bbc.co.uk/news/technology-35890188.

[13]SALHAN K.Copyright law to be tested in AI High Courtcase[EB/OL].(2023-12-19)[2024-09-20].https://gowl ingwlg.com/en/insights-resources/articles/2023/copyright-law- to-be-tested-in-ai-high-court-case.

[14]HERN A.New Ai Fake Text Generator May Be Too Dan gerous to Release,Say Creators[EB/OL].(2019-02-14)[2024-09-20].https://www.theguardian.com/technol ogy/2019/feb/14/elon-musk-backed-ai-writes-convincing-news-fiction.

[15]田野.大数据时代知情同意原则的困境与出路——以生物资料库的个人信息保护为例[J].法制与社会发展,2018,24(6):111 136.

[16]CONFESSORE N.Cambridge Analytica and Facebook:The Scandal and the Fallout So Far[EB/OL].(2018-04-04)[2024-09-22].https://www.nytimes.com/2018/04/04/us/politics/cambridge-analytica-scandal-fallout.html.

[17]国家互联网信息办公室有关负责人就对滴滴全球股份有限公司依法作出网络安全审查相关行政处罚的决定答记者问[EB/OL].(2022-07-21)[2024-09-20].https://www.cac.gov.cn/2022 07/21/c_1660021534364976.htm.

[18]ANSELL C.Collaborative governance in theory and prac tice[J].Journal of Public Administration Research and Theory,2008(4):543–571.

[19]胡颖廉.推进协同治理的挑战[EB/OL].(2016-01-25)[2024-09-21].http://theory.people.com.cn/n1/2016/0125/c49150 28081271.html.

[20]黄晓春,周黎安.政府治理机制转型与社会组织发展[J].中国社会学,2017(11):118 138.

[21]ANSELL C.Collaborative governance in theory and prac tice[J].Journal of Public Administration Research and Theory,2008(4):543–571.

[22]方兴东.从人工智能大模型看大国科技博弈态势[J].人民论坛·学术前沿,2024(13):44 56.

[23]刘琼莲.中国社会治理共同体建设的关键:信任与韧性[J].学习与实践,2020(11):29 39.

[24]中共中央国务院关于构建数据基础制度更好发挥数据要素作用的意见[EB/OL].(2022-12-19)[2024-09-20].https://www.gov.cn/zhengce/2022 12/19/content_5732695.htm.

[25]马允.政府获取平台数据权力的构造与边界[J].山西大学学报(哲学社会科学版),2024(2):49 59.

[26]DASHTI S.Tool-Assisted Risk Analysis for Data Protec tion Impact Assessment[C].Privacy and Identity Man agement.Data for Better Living:AI and Privacy.Cham:Springer,2020:308–324.

[27]SCHNEIDER M.Protecting customer privacy when mar keting with second-party data[J].International Journal of Research in Marketing,2017(4):593–603.

[28]STRATTA M.Automated content warnings for sensitiveposts[C].CHI EA'20:Extended Abstracts of the2020CHI Conference on Human Factors in Computing Sys tems.New York:ACM,2020:1–8.

[29]HACKER P.Regulating ChatGPT and Other Large Gen erative AI Models[C].FAccT'23:Proceedings of the2023ACM Conference on Fairness,Accountability,andTransparency,2023:1112 1123.

[30]张欣.生成式人工智能的算法治理挑战与治理型监管[J].现代法学,2023,45(3):108 123.

[31]RAJI I D,MITCHELL M,SMITH J M,et al.Outsideroversight:Designing a third party audit ecosystem for AIgovernance[C].Proceedings of the2022AAAI/ACMCon ference on AI,Ethics,and Society.New York:ACM,2022:231 242.

[32]范为.大数据时代个人信息保护的路径重构[J].环球法律评论,2016,38(5):92 115.

[33]MERLEC M M,LEE Y K,HONG S P,et al.A smartcontract-based dynamic consent management system forpersonal data usage under GDPR[J].Sensors,2021(23):1 24